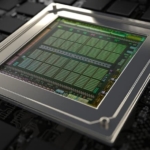

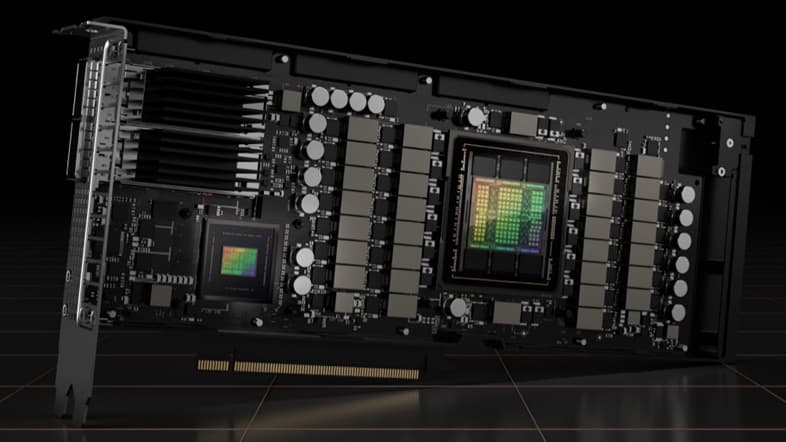

NVIDIA、Hopperアーキテクチャ『NVIDIA H100』を発表

NVIDIAはGTC 2022基調講演にて、Hopperアーキテクチャを採用した『NVIDIA H100』GPUを発表しました。

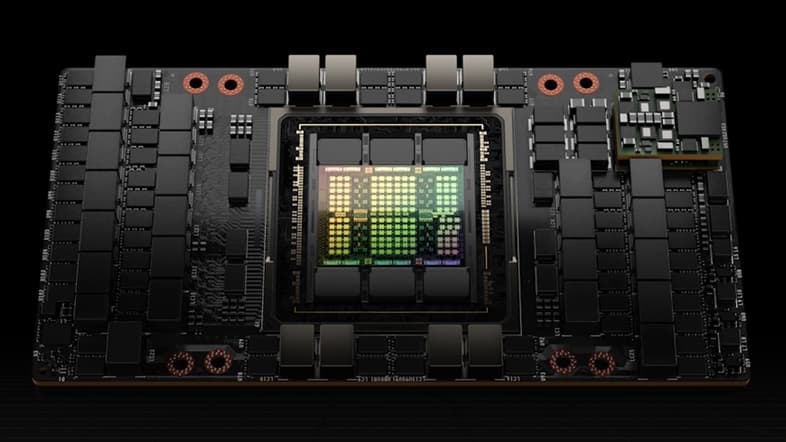

NVIDIA H100はTSMCの4nmプロセスノード(N4)で製造されており、SXM5版のスペックはFP32 CUDAコアが15,872、VRAMがHBM3 80GB。前世代のA100から2倍以上のCUDA数増加が見られます。スペック詳細は以下。

| H100 (SXM5) | H100 (PCIe) | A100 | V100 | P100 | |

| FP32 CUDA | 15,872 | 14,592 | 6,912 | 5,120 | 3,584 |

| FP64 CUDA | 8,448 | 7,296 | 3,456 | 2,560 | 1,792 |

| Memory | 80GB | 80GB | 40GB 80GB | 32GB 16GB | 16GB |

| Memory Bandwidth | 3TB/s | 2TB/s | 40GB 1.6TB/s 80G 2TB/s | 900GB/s | 720GB/s |

| FP16 Tensor TFLOPS | 1,000 2,000 | 800 1,600 | 312 624 | 125 | N/A |

| TF32 Tensor TFLOPS | 500 1,000 | 400 800 | 156 312 | N/A | N/A |

| FP64 Tensor TFLOPS | 60 | 48 | 19.5 | N/A | N/A |

| FP16 TFLOPS | 120 | 96 | 78 | 31.4 | 21.2 |

| FP32 TFLOPS | 60 | 48 | 19.5 | 15.7 | 10.6 |

| FP64 TFLOPS | 30 | 24 | 9.7 | 7.8 | 5.3 |

| Architecture | Hopper | Hopper | Ampere | Volta | Pascal |

| Process | TSMC 4N | TSMC 4N | 7nm | 12nm | 16nm |

| TDP | 700W | 350W | 400W | 300W | 300W |

| Die Size mm² | 814 | 814 | 826 | 815 | 610 |

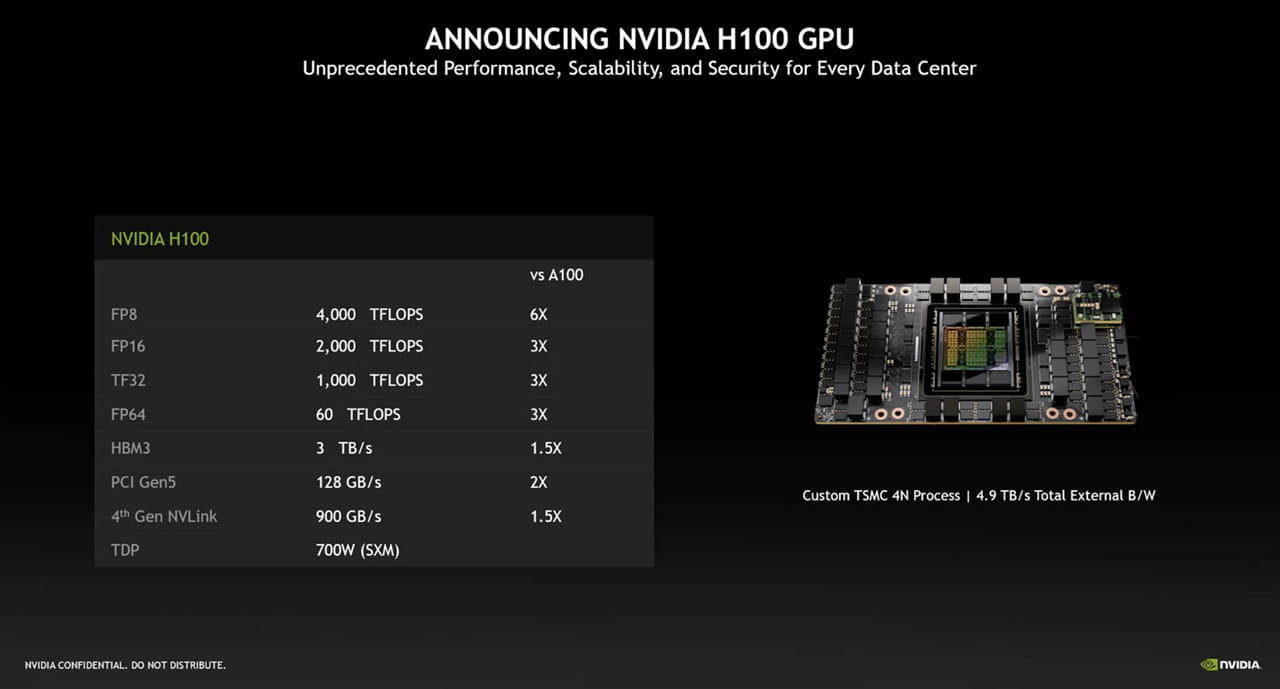

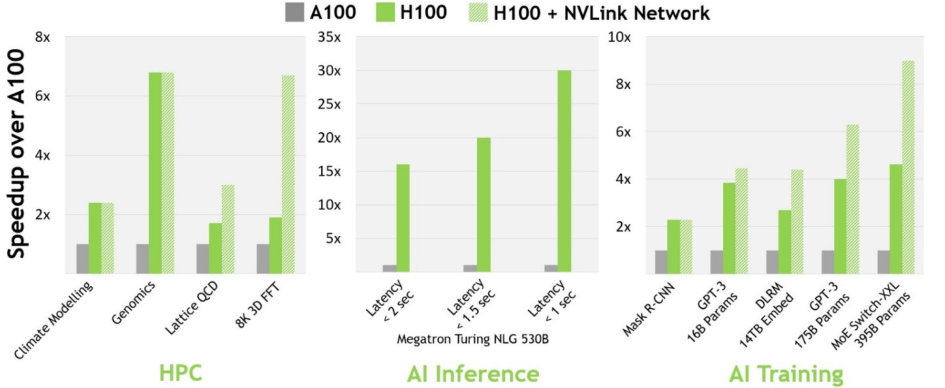

NVIDIAは、H100とA100とを比較すると、以下のようなスペック・パフォーマンス差があることをアピールしています。

NVIDIA H100ファミリー製品は、2022年Q3(7~9月)の出荷が予定されています。